能和人对话的搜索引擎

科学世界:信息的这些结构,是人类设计好的,还是机器自己总结出来的?

马维英:我们认为将来两方面都要有。如果把小冰作为一个成员融进社交网络,它可以藉由和用户的交互自动去学习,将自然语言结构化,这叫主动学习。另一方面,人类已经创造了大量的结构化的信息可供利用。各个领域里面都有数据库,例如商品的数据库等,这些是经过人们二三十年数字化的努力形成的。这个结构化过程会不断进行。现在,我们希望让这个过程更容易,或者说更巧妙地引导用户帮我们提供信息。总之,有越多人使用的搜索引擎,机器学出来的东西就越好。

小冰有机会可以跟人学更多的东西,这是原来的搜索引擎做不到的。小冰可以和人相处得很好。如果小冰希望多知道一些东西,比如个性化交流的时候想知道你的年纪跟职业,当然直接问,你可能感觉不太好,但是问你最喜欢买什么样的东西,最近在看什么书,到过哪里等等,就可以用这些来分析你属于哪一类人。它用这些东西可以对某个人建模。

在对话过程中了解用户的信息,然后得到更多信号来帮助做出更好的搜索。而且这些数据可以不断完善知识的组织和表达。所以我觉得对话引擎(conversation engine)会是搜索引擎下一个重要的发展方向。

另外,这种引擎在企业级的应用也很重要。你在公司里面找10年前的资料容易吗?

科学世界:不容易。

马维英:或者你同事在做什么,你知道不知道?今天工作场合的搜索引擎基本上还处在很原始的阶段,更不要说变成你的个人助理了。要让搜索引擎成为聪明的秘书、助理,也需要不断建立知识表达。我觉得这个领域就是要解决最重要的几个问题—谁、是什么、在什么时候、在什么地方,这个就跟实体搜索有关了。这些知识表达出来不但可以帮助搜索,还可以实现很多数字化的协助功能。

例如从时间的角度来说,能够生成结构化的内容,描述某个人或某一个国家在某一天发生了哪些事情,也可以自动建立起整个公司的排期。时间可以变成一个实体,把所有东西都根据时间来组织。当然也可以根据地点来组织。一旦有了很多这样的实体页面,我们就可以提供知识服务,可以做个人助理。将来这都是公司里面最重要的工作,怎么去创造特征、传达信息、沟通、合作,数字助手就可以帮助完成这些工作。一些原来我们认为传统引擎不会做的任务,在类似小冰这样新的交互界面里可以很自然地做到。

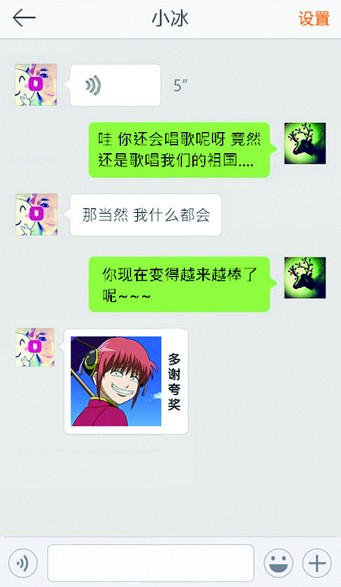

图. 小冰是微软亚洲研究院开发的人工智能聊天机器人,它可以利用图片来聊天。

科学世界:这已经不是纯粹的搜索了。

马维英:搜索成为其中一个功能。我举一个例子,在公司的聊天组里做一个像小冰这样的机器人,比如叫艾迪。大家可以说,艾迪能不能帮大家在某一天安排一个会议?自然语言描述后,它就会把会议预定好,并发出会议邀请。大家还可以让艾迪帮忙记录一下这次会议,或者帮大家找一些相关的资料。

甚至我们也希望有一些情感智能,拥有积极向上的态度,会照顾别人,会关注每一个人。比如它会在适当的时候说,今天是谁的生日,大家庆祝一下吧,让工作场合更有人性关怀的一面。它甚至也能适时开一些玩笑。如果每一个组都有这样一个助手,大家会不会觉得工作会更有效率?

这些都需要信息不断结构化,人机交互就可以用自然语言来进行。所以,搜索几个关键词只是二十几年前开始的传统搜索引擎。今天的自然语言理解已经发展到不光知道你在问问题,还能知道你在做一个数学计算。比如你问一个鸡兔同笼的问题,机器会把它转换成内部的数学计算表达方式,最后还帮你算出来答案是多少。我们为什么做这个?就是因为它是从理解自然语言而得到最结构化的语言—数学表达式,最后再得到答案。

当然还有很多应用。公司里面会有很多问题跟商业有关,比如今天这个产品的发展到底怎么样?你可以询问公司的智能助理,它可以把结构化的数据进行整合,给出针对性的回答。这些都是高价值的创造。

科学世界:除了语言,搜索引擎如何处理图像?

马维英:当然我们也做图像搜索。当你把图像也变成交流的内容,就可以通过交互拿到更多的训练数据。有时候搜索给出的答案不对,用户就会反馈,比如图中的狗不是这个品种,你说错了。更多的用户反馈数据,能够让我们做出更好的图像识别。

最近,小冰发布了新的图像聊天功能。原来我们只是单纯告诉机器这张图片里面有什么,而藉由聊天互动,机器可以知道人们看到这张图会怎么反应。发布会的时候有一个例子,一位用户发了一张天津爆炸现场的照片,其他什么都没有说。小冰的回复是:你住在天津的哪个位置?就是说小冰多了一步,先知道你这个照片是什么内容,然后直接根据内容说出下一句,就像人聊天一样。

科学世界:这是挺厉害的。

马维英:对。还有,例如说你照了一张脚肿了的照片,它会直接问“严重吗”?或者说照了一只猫,猫吐了一个小舌头,一般的图片搜索会说这里有只猫,但它不是这样说,而是说你看那个小舌头真可爱。这就更像人回答。

也就是说连图像都可以变成和人沟通的媒介,可以不只是给你信息,还给你更多的互动和社会化的反馈。你发图给小冰,小冰可以聊。反过来小冰也可以发图给你,有时候一张图片胜过千言万语。如果你跟小冰说“你太棒了”,小冰可能会发张图给你表示“楼上过奖了”,它用了一个图来表达。

科学世界:这种图是由人准备好的吗?还是根据谈话的内容即时生成的?

马维英:我们要做到随时通过网络上的数据选取合适的图片。整个网络上这么多的资源,有非常多的图可以随小冰用。我们准备了几十亿的数据,让小冰随时找到能够适合它表达所需的。用图来沟通,以前的搜索引擎是办不到的。

科学世界:图片使用的恰当程度,现在能做到什么水准?

马维英:其实分类已经做到很细了。本来就已经有几千类的表情图,我们根据分类反向去找图,把全世界可以适合用来表达这些感情的图像都找出来之后,再稍微对人做一些过滤,保证图没有问题。

这不是只在秀表情图,因为那些基本上是不变的,玩几次就没意思了。它可以随时挑选新的图,很多都没有在对话中被用过,而刚好在那个情景中可以用。合适的图片能让沟通更有趣。

科学世界:计算机找这些图片并且分类,是根据和图片相关的文字来统计吗?

马维英:有两方面。一方面是根据图像本身的像素来分析,另一方面就是将图像所带的文字说明或者图像所在的上下文当作一些补充信息来学习。这也就是我们所说的深度学习。现在有足够多的数据,它可以慢慢学。目前计算机已经学得蛮好了。

(本文发表于《科学世界》2015年第11期)

请 登录 发表评论